Unten stehend habe ich meine Herangehensweise für die Präzisierung eines Prompts zur Erstellung des Eintrages für den Wissensglossar aufgeführt und über die Screenshots dokumentiert.

Cloudbasierte KIs (künstliche Intelligenzen) funktionieren, indem sie ihre Rechenleistung, Datenspeicherung und Modelle über das Internet in sogenannten Cloud-Infrastrukturen bereitstellen. Hier ist eine einfache Erklärung, wie das funktioniert:

1. Rechenleistung aus der Cloud

KI-Modelle wie ich brauchen sehr viel Rechenleistung, besonders beim Training oder wenn sie große Aufgaben erledigen. Diese Leistung kommt nicht von deinem Gerät (z. B. Laptop oder Handy), sondern von Rechenzentren(Serverfarmen), die von Anbietern wie Amazon Web Services (AWS), Microsoft Azure, Google Cloud oder OpenAIbetrieben werden.

2. Zugriff auf vortrainierte Modelle

Statt jedes Mal ein KI-Modell neu zu trainieren, nutzen cloudbasierte KIs meist vortrainierte Modelle. Diese wurden mit riesigen Datenmengen (Texte, Bilder, Sprache usw.) trainiert und können dann über die Cloud "gemietet" oder abgerufen werden.

3. Nutzung über eine API

Die KI ist meist über eine sogenannte API (Application Programming Interface) erreichbar. Das heißt:

Du sendest eine Anfrage (z. B. Text, Frage, Bild) an die Cloud.

Die KI verarbeitet das im Rechenzentrum.

Du bekommst das Ergebnis zurück – alles über das Internet.

4. Skalierbarkeit & Wartung

Weil alles zentral in der Cloud läuft:

Können Anbieter schnell skalieren (mehr Nutzer gleichzeitig bedienen).

Müssen Endnutzer keine teure Hardware kaufen.

Werden Updates, Sicherheitsmaßnahmen und Verbesserungen automatisch zentral gepflegt.

Beispiel:

Wenn du ChatGPT in einem Browser benutzt, passiert Folgendes:

Du gibst eine Nachricht ein.

Die Nachricht wird an einen Cloud-Server gesendet.

Dort verarbeitet ein KI-Modell deine Anfrage.

Das Ergebnis wird an deinen Browser zurückgeschickt.

Vorteile:

Keine starke Hardware nötig

Immer aktueller Stand der Technik

Einfacher Zugang über Internet

Große Datenmengen und Rechenleistung möglich

Nachteile:

Abhängigkeit von Internetverbindung

Datenschutz & Sicherheitsbedenken

Laufende Kosten bei häufiger Nutzung

ChatGPT:

Gerne. Als Experte für cloudbasierte Künstliche Intelligenz (KI) erläutere ich dir die Funktionsweise aus technischer und architektureller Perspektive.

Funktionsweise von cloudbasierten KIs – Expertenansicht

1. Grundprinzip: Trennung von Frontend und Backend

Cloudbasierte KIs beruhen auf dem Prinzip, dass die gesamte Datenverarbeitung, Modellinferenz und ggf. auch das Training nicht lokal, sondern in der Cloud erfolgt. Das Frontend (z. B. eine App oder ein Webinterface) dient lediglich als Eingabe- und Ausgabemedium – alle rechenintensiven Prozesse laufen im Backend, also in der Cloud.

2. Systemarchitektur – Überblick

Typische Architekturkomponenten:

| Komponente | Funktion |

|---|---|

| Client (Frontend) | Benutzeroberfläche zur Eingabe (z. B. Web-App, Mobilgerät) |

| API Gateway | Sicherer Einstiegspunkt für Client-Anfragen |

| KI-Service Layer | Endpunkte, die Anfragen entgegennehmen und an Modelle weiterleiten |

| Inferenz-Engine | Führt Modellinferenz durch (z. B. Hugging Face Transformers, TensorFlow Serving, Triton Inference Server) |

| Modell-Repository | Enthält vortrainierte oder benutzerdefinierte Modelle |

| Daten-Pipeline | Optional: Vorverarbeitung, Feature Engineering, Datenvalidierung |

| Monitoring & Logging | Performance- und Fehlerüberwachung |

| Compute-Backend | Skalierbare Recheninstanzen (z. B. GPUs, TPUs, CPUs in Kubernetes-Cluster) |

| Speicher (Blob Store, DB) | Speicherung von Nutzerdaten, Trainingsdaten oder Modellergebnissen |

3. Ablauf einer Inferenz-Anfrage

Eingabe durch den Nutzer (Text, Bild, Sprache, etc.)

Anfrage an API → API Gateway (z. B. AWS API Gateway, Azure API Management)

Routing zur Inferenz-Engine

Beispiel: OpenAI verwendet skalierbare GPU-Cluster hinter Lastverteilern

Vorverarbeitung der Daten

Normalisierung, Tokenisierung, Kodierung je nach Modelltyp

Modellinferenz

Ausführung auf spezialisierter Hardware (meist GPUs oder TPUs)

Nutzung von Frameworks wie TensorFlow, PyTorch oder ONNX

Postprocessing

Rücktransformation in menschenlesbares Format

Antwort an den Client

4. Skalierung und Verfügbarkeit

Cloudbasierte KI-Infrastrukturen nutzen elastische Skalierung durch Container-Orchestrierung (z. B. Kubernetes, AWS ECS, Azure AKS). Das ermöglicht:

Auto-Scaling von Inferenz-Services je nach Last

Load Balancing zwischen Instanzen

Failover-Mechanismen für Hochverfügbarkeit

CI/CD Pipelines für kontinuierliche Bereitstellung von Modellen und Updates

5. Datensicherheit und Datenschutz

Datenverschlüsselung (at rest & in transit)

Zugriffsmanagement über Rollen und Tokens (z. B. OAuth 2.0, IAM)

Audit Logs zur Nachverfolgbarkeit

DSGVO-/HIPAA-Konformität bei personenbezogenen Daten

Für besonders sensitive Szenarien können dedizierte VPCs, Private Endpoints oder sogar On-Prem-zu-Cloud-Hybrideeingesetzt werden.

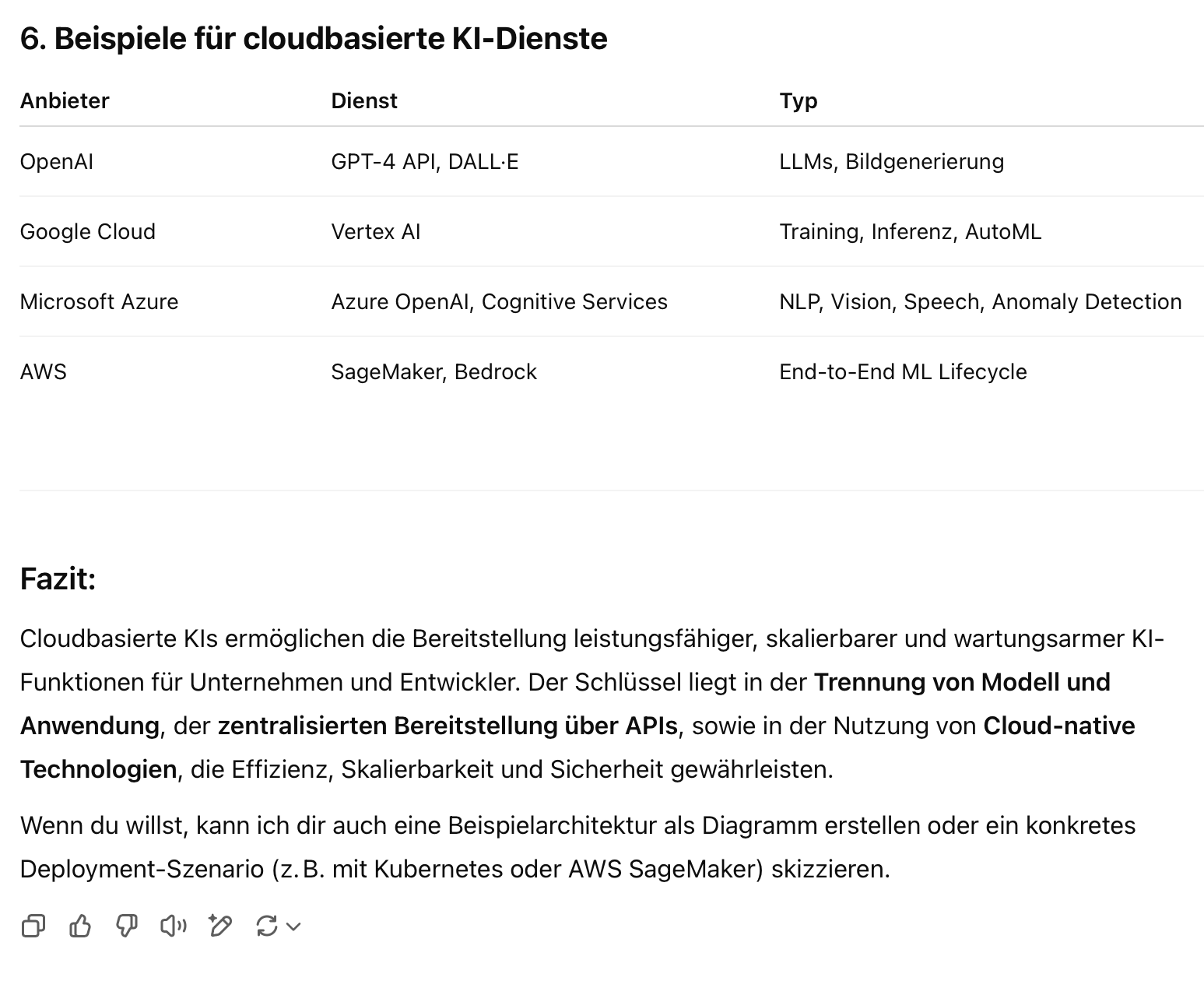

6. Beispiele für cloudbasierte KI-Dienste

| Anbieter | Dienst | Typ |

|---|---|---|

| OpenAI | GPT-4 API, DALL·E | LLMs, Bildgenerierung |

| Google Cloud | Vertex AI | Training, Inferenz, AutoML |

| Microsoft Azure | Azure OpenAI, Cognitive Services | NLP, Vision, Speech, Anomaly Detection |

| AWS | SageMaker, Bedrock | End-to-End ML Lifecycle |

Fazit:

Cloudbasierte KIs ermöglichen die Bereitstellung leistungsfähiger, skalierbarer und wartungsarmer KI-Funktionen für Unternehmen und Entwickler. Der Schlüssel liegt in der Trennung von Modell und Anwendung, der zentralisierten Bereitstellung über APIs, sowie in der Nutzung von Cloud-native Technologien, die Effizienz, Skalierbarkeit und Sicherheit gewährleisten.

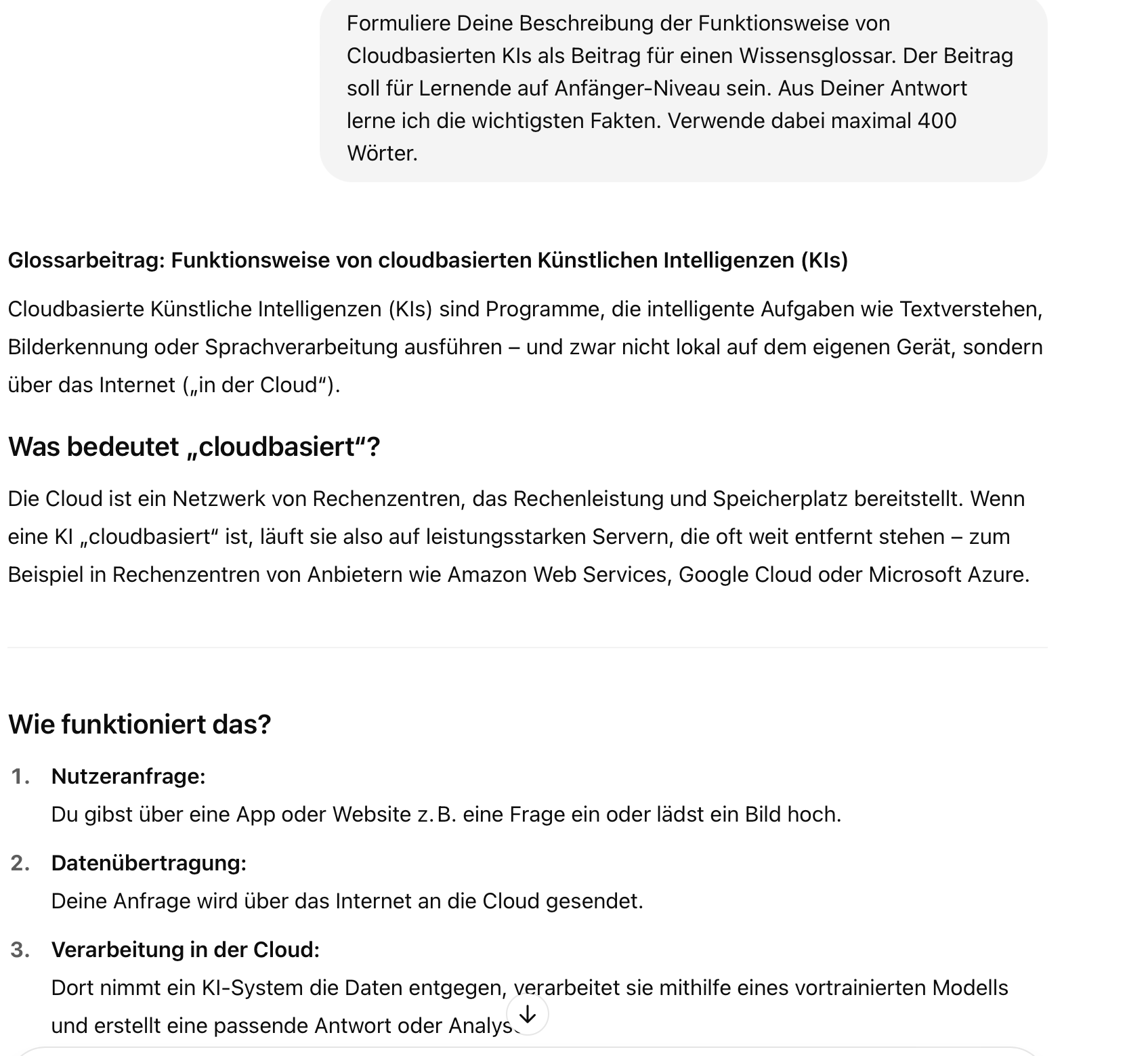

Glossarbeitrag: Funktionsweise von cloudbasierten Künstlichen Intelligenzen (KIs)

Cloudbasierte Künstliche Intelligenzen (KIs) sind Programme, die intelligente Aufgaben wie Textverstehen, Bilderkennung oder Sprachverarbeitung ausführen – und zwar nicht lokal auf dem eigenen Gerät, sondern über das Internet („in der Cloud“).

Was bedeutet „cloudbasiert“?

Die Cloud ist ein Netzwerk von Rechenzentren, das Rechenleistung und Speicherplatz bereitstellt. Wenn eine KI „cloudbasiert“ ist, läuft sie also auf leistungsstarken Servern, die oft weit entfernt stehen – zum Beispiel in Rechenzentren von Anbietern wie Amazon Web Services, Google Cloud oder Microsoft Azure.

Wie funktioniert das?

Nutzeranfrage:

Du gibst über eine App oder Website z. B. eine Frage ein oder lädst ein Bild hoch.Datenübertragung:

Deine Anfrage wird über das Internet an die Cloud gesendet.Verarbeitung in der Cloud:

Dort nimmt ein KI-System die Daten entgegen, verarbeitet sie mithilfe eines vortrainierten Modells und erstellt eine passende Antwort oder Analyse.Rückgabe des Ergebnisses:

Die Antwort wird wieder an dein Gerät gesendet – meist in Sekundenschnelle.

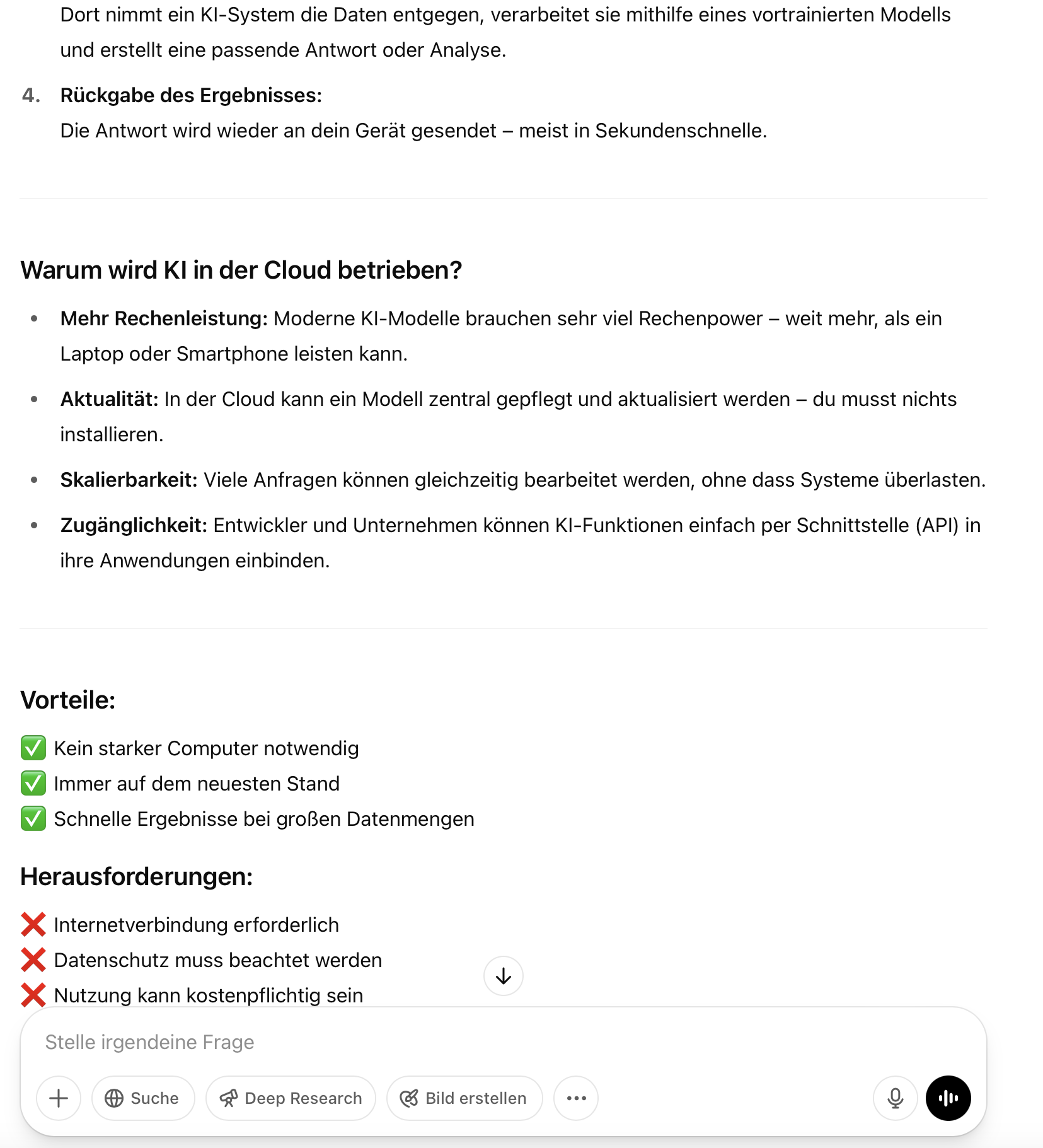

Warum wird KI in der Cloud betrieben?

Mehr Rechenleistung: Moderne KI-Modelle brauchen sehr viel Rechenpower – weit mehr, als ein Laptop oder Smartphone leisten kann.

Aktualität: In der Cloud kann ein Modell zentral gepflegt und aktualisiert werden – du musst nichts installieren.

Skalierbarkeit: Viele Anfragen können gleichzeitig bearbeitet werden, ohne dass Systeme überlasten.

Zugänglichkeit: Entwickler und Unternehmen können KI-Funktionen einfach per Schnittstelle (API) in ihre Anwendungen einbinden.

Vorteile:

Kein starker Computer notwendig

Immer auf dem neuesten Stand

Schnelle Ergebnisse bei großen Datenmengen

Herausforderungen:

Internetverbindung erforderlich

Datenschutz muss beachtet werden

Nutzung kann kostenpflichtig sein

Fazit:

Cloudbasierte KIs machen moderne künstliche Intelligenz für viele Menschen und Unternehmen zugänglich – schnell, skalierbar und leistungsstark. Sie sind ein zentraler Bestandteil der digitalen Zukunft.